ADVERTORIAL

von Dr. Martin Böckle, Lead Strategic Designer, BCG Platinion

Sophia Maier, Senior IT Consultant, BCG Platinion

Dr.-Ing. Nico Rödder, Manager, BCG Platinion

Tatort Twitter im März 2016: Ein Account mit dem Namen TayTweets erschüttert das Internet durch eine Reihe anstößiger und kontroverser Kurznachrichten. So weit, so gewöhnlich, könnte man meinen. Allerdings handelte es sich bei TayTweets um einen „Twitter Bot“ von Microsoft, der sich auf Basis der Interaktion mit menschlichen Nutzern weiterentwickelt und eigene „menschenähnliche“ Charakterzüge entwickeln sollte. Was von Microsoft als Demonstration der eigenen Fähigkeiten und Technologie im Bereich Künstlicher Intelligenz (KI) vorgesehen war, führte zu einem PR-Desaster.

Statt Tay mit dem Wahren, Schönen und Guten der Menschheit zu „füttern“, entschieden sich Twitter-Nutzer in der Mehrzahl dazu, den Bot mit menschlichen Abgründen zu überfluten. Es dauerte nur wenige Stunden, bis der unter Laborbedingungen entwickelte „unvoreingenommene“ Bot offensichtlich rassistische und extremistische Inhalte „lernte“, diese selbst unkontrolliert twitterte und als letzte Konsequenz darauf offline genommen wurde.

Alltäglichkeit von KI steigert Diskussionsbedarf

Auch wenn Tay durch einseitige Fragen und Aussagen von „Trolls“ gezielt beeinflusst wurde, untermauerte der Vorfall die Debatte um das Risiko des Einflusses von (realen) Trainingsdaten auf KI oder auf Machine Learning (ML) basierende Algorithmen. Dazu kommt eine intensiver werdende Diskussion um die Notwendigkeit einer stärkeren menschlichen Nachvollziehbarkeit von KI-basierten Ergebnissen und Entscheidungsempfehlungen.

Seit TayTweets sind über fünf Jahre vergangen, die Technologien haben sich weiterentwickelt, funktionsreiche KI-(Teil-)Applikationen haben in unserem privaten sowie beruflichen Alltag Einzug gehalten und sind daraus nicht mehr wegzudenken. Zum Beispiel in der Medizin, in der KI zur Klassifizierung von Computertomographie-Bildern eingesetzt wird, um die Frühdiagnose von Netzhauterkrankungen zu unterstützen, oder im Bankwesen, wo Anwendungen den Nutzern beim Risikomanagement und bei Entscheidungen der Preisgestaltung helfen. Trotz der vielen positiven Beispiele stellt das Design von nutzerzentrierten intelligenten Systemen, welches die Bedürfnisse und Ziele der End-Nutzer berücksichtigt, noch immer eine große Herausforderung dar.

Die Debatte um KI und ihre Auswirkungen auf die Gesellschaft, zunächst in Expertenkreisen geführt und durch Beispiele wie Tay einer breiteren Masse bewusst gemacht, scheint mit jedem erschlossenen Anwendungsgebiet noch präsenter zu werden und hat nun auch die politische Bühne etwa über die Arbeitsgruppe Mensch und Maschine des Deutschen Ethikrats erreicht.

EU-Regulierung könnte Handlungsdruck nach mehr Erklärbarkeit von KI-Lösungen erhöhen

Die EU-Kommission hat im April 2021 erstmals einen Vorschlag für einen Rechtsrahmen zur Regulierung von KI vorgelegt. Der Entwurf zur Festlegung harmonisierter Vorschriften für KI (2021/0106(COD)) zielt neben dem Verbot von sicherheits-, lebensgrundlagen- und menschenrechtsbedrohender KI insbesondere auf die Verbreitung ethischer IT sowie der Steigerung des Vertrauens der Bürger in KI-gestützte Systeme ab. Entlang eines risikobasierten Ansatzes sollen KI-getriebene Applikationen gemäß ihres Einsatzgebietes kategorisiert werden und EU-weiten Auflagen und Standards unterliegen. Insbesondere für Anwendungen in datenkritischen Bereichen wie im Personalmanagement oder der Strafverfolgungsinfrastruktur sollen mit Verabschiedung der Verordnung strenge Vorgaben hinsichtlich Dokumentation, Transparenz und Sicherheit gelten. Aber auch Anwendungen wie Chatbots, die von Unternehmen zur Kundenbetreuung eingesetzt werden, sollen klare Transparenzverpflichtungen erfüllen. Der Vorschlag der EUKommission muss zunächst das ordentliche Gesetzgebungsverfahren durchlaufen und richtet sich derzeit vormerklich auf Anwendungen in kritischen Domänen. Zusammen mit den bereits vorhandenen Anforderungen im Datenschutzrecht steigert dieser Vorschlag aber weiter den bereits heute spürbaren öffentlichen Handlungsdruck auf Entwickler und Unternehmen nach mehr Transparenz, welcher bislang hauptsächlich aus der Richtung der IT-Ethik und der End-Nutzer-Forschung zu vernehmen war.

Die meisten End-Nutzer verzichten nur ungern auf die Annehmlichkeiten alltäglich genutzter Apps und Geschäftsanwendungen. Jedoch hängen ihr Vertrauen und im Umkehrschluss die Akzeptanz maßgeblich von der menschlichen Nachvollziehbarkeit der Funktionalität und des Ergebnisses ab. Vier Elemente können diese gewährleisten:

1. Die technische Nachvollziehbarkeit, also die Verständlichkeit der technischen Softwarelösung und deren Quellcode für Experten

2. Die funktionale/logische Nachvollziehbarkeit des Models, also die Information, warum und wie welche Input-Daten und zugrundeliegende Annahmen zu einem Ergebnis führen

3. Die korrekte Interpretation dieser Information

4. Die verständliche Aufbereitung und Vermittlung des Wissens an die Nutzenden durch Ansätze wie „erklärbare KI“ (explainable Artificial Intelligence – XAI)

Dieses Konzept ist trotz erklärbarer Algorithmen bis heute in den wenigsten Anwendungen zu finden. Hier kann KI-spezifisches strategisches Design eine Schlüsselrolle spielen. Dazu gehört etwa Design Thinking als eine Methode zur systematischen Lösung komplexer Probleme und der Entwicklung neuer Ideen in der Schnittmenge von „wünschenswert für Nutzer“ (Desireability), „technische Durchführbarkeit“ (Feasability)“ und „Rentabilität für das Unternehmen“ (Viability). Weniger getrieben von den technischen Möglichkeiten, stehen bei der Entwicklung von praxisnahen Ergebnissen die Bedürfnisse und Ziele der Endnutzer im Mittelpunkt.

Strategisches Design erhöht Nachvollziehbarkeit und Akzeptanz von KI-Lösungen

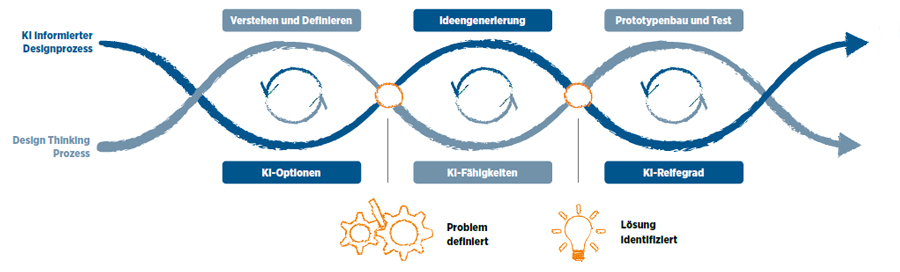

Für die Entwicklung nutzerzentrierter KI-Anwendungen mit einem hohen Grad an Nachvollziehbarkeit sollte ein iterativer Ansatz mit dem Ziel einer reibungslosen Nutzererfahrung für die Interaktion zwischen Mensch und KI-Anwendung verfolgt werden:

1. Identifikation von Nutzerbedürfnissen über ethnographische Forschung oder Fragebögen und Untersuchung auf KI-Optionen

2. Ideengenerierung, um die Potenziale der KI mit den Nutzeranforderungen abzugleichen und Datenanforderungen abzuleiten

3. Ideenumsetzung in einem ersten Prototyp, wobei der KI-Reifegrad speziell zu Beginn der Nutzung eine Herausforderung darstellt

Bei der Entwicklung der Nutzeroberfläche (User Interface, UI) und der Benutzererfahrung (User Experience, UX) von KI-Anwendungen ist die Repräsentation und Interpretation der Ausgabe von hoher Wichtigkeit und wird aktuell unter dem Stichwort „erklärbare KI“ (XAI) in Forschung und Entwicklung mit dem Ziel diskutiert, das Vertrauen bei der Interaktion zwischen Nutzer und KILösung zu steigern. Als Input für Designpraktiken, speziell in der Konzeptions- und Prototypenphase, dienen Ergebnisse aus anwendungsorientierten Forschungsgebieten wie zum Beispiel der Mensch-Computer-Interaktion (Human-Computer Interaction, HCI), welche sich mit Design und Nutzung von interaktiven digitalen Systemen auseinandersetzen. In Forschung und (System-) Entwicklung werden bereits Taxonomien für nutzerzentriertes Design herangezogen:

- Was wird erklärt? (z. B. Modell oder Daten)

- Wie wird es erklärt? (z. B. direkt/post-hoc, statisch oder interaktiv)

- Welches Format? (z. B. Text, Bild, Tabellenformat etc.)

Der Ansatz einer nutzerzentrierten erklärbaren KI hat auch das Ziel, die Nutzererfahrung an die jeweilige Nutzergruppe anzupassen. So sollte sich die Ausgabe zwischen normalen Nutzern und technikaffinen Fachexperten unterscheiden, um auf die jeweiligen Bedürfnisse der Zielgruppe einzugehen und die Akzeptanz und Zufriedenheit zu erhöhen. Von dieser Kundenzufriedenheit sowie der vorangehenden Transparenzsteigerung und dem dadurch adressierten Handlungsdruck profitieren die Anbieter der genutzten Applikationen.

Denn längst gilt, dass KI-Applikationen nicht nur bisher unerkannte Schätze in Daten durch die Erkennung von Mustern heben, sondern insbesondere Mitarbeitende von repetitiven Tätigkeiten befreien können, um sich Aufgaben zu widmen, die kreative Lösungen erfordern. Eine Förderung der Nutzung derartiger Applikationen durch eine Erhöhung der Nachvollziehbarkeit ist zudem nicht nur aus Gründen von Effektivität und Effizienz sinnvoll, sondern kann auch ein wesentlicher Baustein bei der Erfüllung etwaiger regulatorischer Anforderungen bilden. Somit kann sich der Einsatz strategischen Designs in der Entwicklung von KI-Anwendungen nicht nur profitabel auf Anwender und Anbieter auswirken, sondern auch weitere Beiträge in der KI-Debatte und auch bei der Regulierung von KI-Applikationen leisten.

Akzeptanz fördert Nutzungsintensität

Für Unternehmen ist die Akzeptanz und Nutzungsintensität neu eingesetzter KI-Lösungen von kritischer Bedeutung. In geplanten und bereits laufenden KI-Initiativen müssen strategische Design-Praktiken nicht nur berücksichtigt werden, sondern eine zentrale Rolle spielen, um nutzerzentrierte Lösungen mit einer breiten Akzeptanz sicherzustellen. Schlussendlich spielt nicht nur die Leistung der KI-Lösung und die Qualität der zugehörigen Daten eine wichtige Rolle, sondern auch die Nutzerbedürfnisse sind von entscheidender Bedeutung für den Erfolg der KI-Lösung.